SEO für Einsteiger – Teil 4: SEO-Dschungel – Wo fange ich eigentlich mit SEO an?

4. Mai 2018 | Von Andreas Engelhardt in SEO

In meiner SEO-Einsteigerserie bin ich bislang auf zentrale Begriffe, wie Keywords, Linkaufbau, Indexierung und Crawling, eingegangen. Thema heute: Wo fange ich eigentlich am besten an? Was sind die ersten Schritte bei der Suchmaschinenoptimierung? Dieser Beitrag soll Licht in den SEO-Dschungel bringen.

Die Arbeit eines SEOs unterteilt sich in zwei große Teile:

Die Arbeit eines SEOs unterteilt sich in zwei große Teile:

- On-Page-Optimierung

- Off-Page-Optimierung (Linkaufbau)

Bestandsaufnahme

Um mit der Optimierung zu beginnen, lohnt es sich erst einmal zu schauen, was eigentlich an Seiten, also an eigenständigen URLs, vorhanden ist. Je nach Seitengröße kann man dabei schnell den Überblick verlieren. Tools, wie der Screaming Frog SEO Spider, helfen dabei, die Seite zu analysieren, indem sie die Seite (ähnlich wie der Google-Bot) crawlen und einem eine Übersicht aller URLs inkl. Seitentitel, Meta Description und Überschriften ausgeben. Bis zu 500 URLs können mit der Gratisversion des Screaming Frogs gecrawlt werden.A) On-Page-Optimierung

Wie der Name schon verrät, werden unter der On-Page-Optimierung alle Maßnahmen zusammengefasst, die die Seite betreffen. Das schließt sowohl die technischen als auch die inhaltlichen Aspekte einer Seite ein.Technische Rahmenbedingungen (Technisches SEO)

Damit Optimierungsmaßnahmen überhaupt greifen können, ist es wichtig, dass die technischen Grundlagen der Seite stehen. Zu den absoluten Basics zählen: Crawling und Indexierung Ist die Robots.txt und – falls vorhanden – sind die Robots Meta-Tags in Ordnung, damit Crawling und Indexierung korrekt gesteuert werden können? Sicherheitsaspekte Stehen die Seiten auf https? Für Google spielt Sicherheit eine große Rolle. Als sicheres Hypertext-Übertragungsprotokoll sollte der HTTPS-Standard verwendet werden, denn ab Juli stuft Google Seiten in Google Chrome, die nicht auf den HTTPS migriert sind, als „nicht sicher“ ein. Seitenladegeschwindigkeit Eine schnelle Seitenladegeschwindigkeit sorgt für ein gutes Nutzererlebnis. Wer seine Seitengeschwindigkeit optimieren möchte, erhält mit dem Tools PageSpeedInsights von Google erste Anhaltspunkte. Extrem lange Ladezeiten können das Ranking beeinträchtigen. Mobile Tauglichkeit Sind die Seiten responsiv, also mobil optimiert? Auch hier gibt es ein Tool aus dem Hause Google, welches die mobile Tauglichkeit überprüft.Inhaltliche Maßnahmen

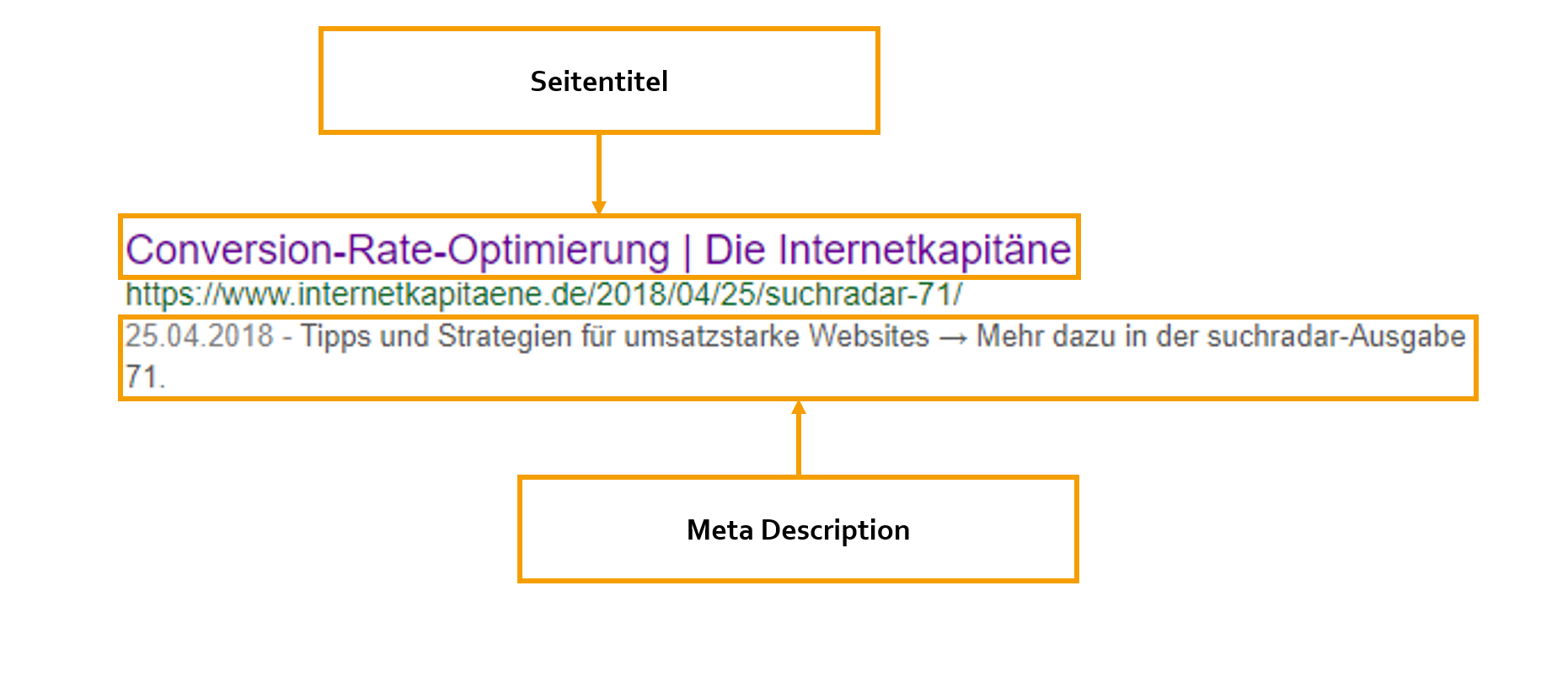

Im nächsten Schritt kümmern wir uns um den Seiteninhalt. Dazu ziehen wir die Informationen aus dem Crawl, die wir z. B. in eine Excel-Tabelle exportiert haben, zu Rate. Die Excel-Tabelle kann schnell in eine Keyword-Map erweitert werden. Entlang der Seitenstruktur können wir nun mit der Optimierung der einzelnen Seiten beginnen. Häufig ist es so, dass auf der Startseite und auf dezidierten Landingpages der meiste Traffic landet bzw. landen soll. Dann kommen die Rubrikenseiten und schließlich die Detailseiten. In dieser Reihenfolge sollte die Optimierung in der Regel angegangen werden. Darstellung der Suchergebnisse Um die Klicks auf ein Suchergebnis zu steigern, kann die Darstellung der Suchergebnisse optimiert werden. Primär geschieht das durch die Anpassung des Seitentitels und der Meta Description. Je nach Suchanfrage spielt Google diese Informationen aus, wie das folgende Beispiel zeigt. Der Seitentitel sollte einzigartig sein und zum Klicken anregen. Selbstverständlich sollte er den Suchbegriff enthalten, für welchen die Seite optimiert wird. Hier helfen die Ergebnisse der Keyword-Recherche. An den eigentlichen Seitentitel darf gerne noch die Brand angehängt werden. Je nach Breite der einzelnen Buchstaben in Pixeln sollte der Seitentitel aus ca. 50 bis 60 Zeichen bestehen.

Auch die Meta Description sollte einzigartig sein und wesentliche Suchbegriffe enthalten. Diese werden bei der entsprechenden Suchanfrage im Snippet gefettet. Auch wenn Google teilweise längere Meta Descriptions ausgibt und hier viel getestet wird, ist man mit ca. 155 Zeichen auf der sicheren Seite.

Sind Seitentitel oder Meta Descriptions nicht einzigartig, werden die Daten von der Suchmaschine verworfen. Sind Seiten nicht für die Suche relevant, können die entsprechenden Felder im Content-Management-System auch einfach leer gelassen werden.

Text und Überschriften

Besondere Bedeutung kommt der Hauptüberschrift zu. Diese ist im Quellcode in der Regel als <h1> ausgewiesen. Sie fällt dem Nutzer besonders ins Auge bzw. sollte das tun. Sie gibt ihm Orientierung und, wenn alles optimiert ist, das Gefühl „Du hast gefunden, was du gesucht hast – an dieser Stelle bist du richtig“. Grundsätzlich sollte sich die Hauptüberschrift zumindest leicht vom Seitentitel unterscheiden. Sie könnte also z. B. noch eine Handlungsempfehlung an den Nutzer enthalten. Eine Längenbegrenzung gibt es per se nicht. Dennoch sollte eine gute Lesbarkeit gewahrt werden.

Bei der Strukturierung der Seite sollte man ebenfalls stets an seine Nutzer denken. Zwischenüberschriften, die im Quellcode mit <hx>-Elementen ausgezeichnet werden, geben den Nutzer einen besseren Überblick und schaffen Strukturen im Text.

Das Thema Text ist grundsätzlich komplex. Zu Beginn der Seitenoptimierung sollte auf jeden Fall darauf geachtet werden, dass die wesentlichen Seiten überhaupt über einen Text verfügen. Das macht es Google wesentlich einfacher zu begreifen, worum es auf der Seite überhaupt geht. Grundsätzlich gilt es, Texte mit hoher Qualität und Mehrwert für den Nutzer auf die Seite zu bringen. Auch bei der Länge kann man sich gut am Nutzer orientieren. Komplexe Themen bedürfen nun einmal ausführlichen Erklärungen. Auch Elemente, wie z. B. Bilder, Videos und Infografiken, können die Qualität einer Seite erhöhen. Mehr Infos zu guten Texten findet man im Blogbeitrag von Andreas Schülke.

Seitenstruktur

Wie bereits erwähnt, sollte man sich beim Optimieren an der Seitenstruktur orientieren, aber auch die Seitenstruktur selbst sollte kritisch überprüft werden. Ziel ist es dabei konstante Seiten aufzubauen, die sich an den Suchbegriffen der Nutzer orientieren. In einem Shop verschwinden beispielsweise Produktedetailseiten häufiger, weil neue Kollektionen kommen und die „alten“ Produkte abverkauft sind. Strukturseiten, wie Rubrikenseiten und deren Unterseiten und sogar Unterunterseiten etc., helfen dabei, konstante Seiten aufzubauen, die langfristig existieren und so überhaupt die Chance haben, zu ranken. Auch hier helfen die Ergebnisse der Keyword-Recherche. Für Suchbegriffe mit viel Suchvolumen lohnt es sich, eigene Strukturseiten einzurichten.

Interne Verlinkung

Damit die Seitenstruktur auch von Google verstanden werden und Google alle Seiten finden kann, sollten die Seiten innerhalb der Website verlinkt sein. Mit der internen Verlinkung kann der Suchmaschine gezeigt werden, welche Seiten wichtiger und welche Seiten weniger wichtig sind. Was hier verteilt wird, nennt man Link Juice, also so etwas wie „Linksaft“. Der Link Juice auf der Startseite ist meistens am höchsten. Existieren jetzt beispielsweise zwei Rubrikenseiten die von der Startseite aus verlinkt werden, verteilt sich der Link Juice auch auf diese. Fügt man den Rubrikenseiten nun weitere Unterseiten hinzu und verlinkt diese, verteilt sich der Link Juice mit jedem weiteren Link immer mehr. Beim Optimieren gilt deswegen, wichtigen Seiten entsprechend viel Link Juice zuzuteilen und für die Suche weniger relevante Seiten mit weniger Link Juice zu versehen.

Hinzu kommt ein weiterer Aspekt der internen Verlinkung, die Klicktiefe. Diese beschreibt, wie viele Klicks – ausgehend von der Startseite – nötig sind, um auf einen bestimmten Seiteninhalt zu kommen. Die Klicktiefe kann auch mit dem Screaming Frog gemessen werden.

Wie Google die Wichtigkeit der einzelnen Seiten tatsächlich bewertet, ist eine Black-Box und hängt wahrscheinlich noch von weiteren Faktoren ab. Dennoch helfen die beiden Modelle dabei, ein Verständnis für die Wichtigkeit einzelner Seiten zu entwickeln. Es gibt zwar Tools, die versuchen den Link Juice zu berechnen, aber es ist fraglich, ob Google diesen auf gleiche Weise berechnet. Auch da lässt Google sich wie gewohnt nicht in die Karten schauen, um Manipulation zu vermeiden.

Für die Optimierung lässt sich aber festhalten, dass von der Startseite gezielt auf die wichtigsten Seiten, wie z. B. Top Rubriken, Top Produkte oder wichtige Marken, zu verlinken. Das Vorgehen sollte auch bei der Strukturierung des Menüs beachtet werden.

Duplicate Content

Duplicate Content wird in zwei Formen unterschieden. Zum einen der interne Duplicate Content, der auf der eigenen Seite existieren kann und zum anderen der externe Duplicate Content, wenn gleiche Inhalte auf unterschiedlichen Domains liegen.

Ein Beispiel für internen Duplicate Content kann z. B. sein, dass zwei Seiten wie http://www.beispielseite.de/ und http://www.beispielseite.de/index.php den gleichen Inhalt aufweisen. Das Problem mit internem Duplicate Content kann mit dem Canonical Tag gelöst werden. Als Quelle für die Indexierung wird dann lediglich die kanonische URL genutzt. Dazu muss im Quellcode der <head>-Bereich um das Canonical Tag ergänzt werden: <link rel=“canonical“ href=““/>

Externer Duplicate Content muss zunächst einmal identifiziert werden. Dazu hilft die Google-Suche nach ganzen Phrasen oder Seiten wie www.copyscape.com. Mögliche Probleme, die durch externen Duplicate Content auftreten, sind:

Der Seitentitel sollte einzigartig sein und zum Klicken anregen. Selbstverständlich sollte er den Suchbegriff enthalten, für welchen die Seite optimiert wird. Hier helfen die Ergebnisse der Keyword-Recherche. An den eigentlichen Seitentitel darf gerne noch die Brand angehängt werden. Je nach Breite der einzelnen Buchstaben in Pixeln sollte der Seitentitel aus ca. 50 bis 60 Zeichen bestehen.

Auch die Meta Description sollte einzigartig sein und wesentliche Suchbegriffe enthalten. Diese werden bei der entsprechenden Suchanfrage im Snippet gefettet. Auch wenn Google teilweise längere Meta Descriptions ausgibt und hier viel getestet wird, ist man mit ca. 155 Zeichen auf der sicheren Seite.

Sind Seitentitel oder Meta Descriptions nicht einzigartig, werden die Daten von der Suchmaschine verworfen. Sind Seiten nicht für die Suche relevant, können die entsprechenden Felder im Content-Management-System auch einfach leer gelassen werden.

Text und Überschriften

Besondere Bedeutung kommt der Hauptüberschrift zu. Diese ist im Quellcode in der Regel als <h1> ausgewiesen. Sie fällt dem Nutzer besonders ins Auge bzw. sollte das tun. Sie gibt ihm Orientierung und, wenn alles optimiert ist, das Gefühl „Du hast gefunden, was du gesucht hast – an dieser Stelle bist du richtig“. Grundsätzlich sollte sich die Hauptüberschrift zumindest leicht vom Seitentitel unterscheiden. Sie könnte also z. B. noch eine Handlungsempfehlung an den Nutzer enthalten. Eine Längenbegrenzung gibt es per se nicht. Dennoch sollte eine gute Lesbarkeit gewahrt werden.

Bei der Strukturierung der Seite sollte man ebenfalls stets an seine Nutzer denken. Zwischenüberschriften, die im Quellcode mit <hx>-Elementen ausgezeichnet werden, geben den Nutzer einen besseren Überblick und schaffen Strukturen im Text.

Das Thema Text ist grundsätzlich komplex. Zu Beginn der Seitenoptimierung sollte auf jeden Fall darauf geachtet werden, dass die wesentlichen Seiten überhaupt über einen Text verfügen. Das macht es Google wesentlich einfacher zu begreifen, worum es auf der Seite überhaupt geht. Grundsätzlich gilt es, Texte mit hoher Qualität und Mehrwert für den Nutzer auf die Seite zu bringen. Auch bei der Länge kann man sich gut am Nutzer orientieren. Komplexe Themen bedürfen nun einmal ausführlichen Erklärungen. Auch Elemente, wie z. B. Bilder, Videos und Infografiken, können die Qualität einer Seite erhöhen. Mehr Infos zu guten Texten findet man im Blogbeitrag von Andreas Schülke.

Seitenstruktur

Wie bereits erwähnt, sollte man sich beim Optimieren an der Seitenstruktur orientieren, aber auch die Seitenstruktur selbst sollte kritisch überprüft werden. Ziel ist es dabei konstante Seiten aufzubauen, die sich an den Suchbegriffen der Nutzer orientieren. In einem Shop verschwinden beispielsweise Produktedetailseiten häufiger, weil neue Kollektionen kommen und die „alten“ Produkte abverkauft sind. Strukturseiten, wie Rubrikenseiten und deren Unterseiten und sogar Unterunterseiten etc., helfen dabei, konstante Seiten aufzubauen, die langfristig existieren und so überhaupt die Chance haben, zu ranken. Auch hier helfen die Ergebnisse der Keyword-Recherche. Für Suchbegriffe mit viel Suchvolumen lohnt es sich, eigene Strukturseiten einzurichten.

Interne Verlinkung

Damit die Seitenstruktur auch von Google verstanden werden und Google alle Seiten finden kann, sollten die Seiten innerhalb der Website verlinkt sein. Mit der internen Verlinkung kann der Suchmaschine gezeigt werden, welche Seiten wichtiger und welche Seiten weniger wichtig sind. Was hier verteilt wird, nennt man Link Juice, also so etwas wie „Linksaft“. Der Link Juice auf der Startseite ist meistens am höchsten. Existieren jetzt beispielsweise zwei Rubrikenseiten die von der Startseite aus verlinkt werden, verteilt sich der Link Juice auch auf diese. Fügt man den Rubrikenseiten nun weitere Unterseiten hinzu und verlinkt diese, verteilt sich der Link Juice mit jedem weiteren Link immer mehr. Beim Optimieren gilt deswegen, wichtigen Seiten entsprechend viel Link Juice zuzuteilen und für die Suche weniger relevante Seiten mit weniger Link Juice zu versehen.

Hinzu kommt ein weiterer Aspekt der internen Verlinkung, die Klicktiefe. Diese beschreibt, wie viele Klicks – ausgehend von der Startseite – nötig sind, um auf einen bestimmten Seiteninhalt zu kommen. Die Klicktiefe kann auch mit dem Screaming Frog gemessen werden.

Wie Google die Wichtigkeit der einzelnen Seiten tatsächlich bewertet, ist eine Black-Box und hängt wahrscheinlich noch von weiteren Faktoren ab. Dennoch helfen die beiden Modelle dabei, ein Verständnis für die Wichtigkeit einzelner Seiten zu entwickeln. Es gibt zwar Tools, die versuchen den Link Juice zu berechnen, aber es ist fraglich, ob Google diesen auf gleiche Weise berechnet. Auch da lässt Google sich wie gewohnt nicht in die Karten schauen, um Manipulation zu vermeiden.

Für die Optimierung lässt sich aber festhalten, dass von der Startseite gezielt auf die wichtigsten Seiten, wie z. B. Top Rubriken, Top Produkte oder wichtige Marken, zu verlinken. Das Vorgehen sollte auch bei der Strukturierung des Menüs beachtet werden.

Duplicate Content

Duplicate Content wird in zwei Formen unterschieden. Zum einen der interne Duplicate Content, der auf der eigenen Seite existieren kann und zum anderen der externe Duplicate Content, wenn gleiche Inhalte auf unterschiedlichen Domains liegen.

Ein Beispiel für internen Duplicate Content kann z. B. sein, dass zwei Seiten wie http://www.beispielseite.de/ und http://www.beispielseite.de/index.php den gleichen Inhalt aufweisen. Das Problem mit internem Duplicate Content kann mit dem Canonical Tag gelöst werden. Als Quelle für die Indexierung wird dann lediglich die kanonische URL genutzt. Dazu muss im Quellcode der <head>-Bereich um das Canonical Tag ergänzt werden: <link rel=“canonical“ href=““/>

Externer Duplicate Content muss zunächst einmal identifiziert werden. Dazu hilft die Google-Suche nach ganzen Phrasen oder Seiten wie www.copyscape.com. Mögliche Probleme, die durch externen Duplicate Content auftreten, sind:

- Meine Seite wird nicht in den Index aufgenommen, weil der Crawler Dubletten finden.

- Mein Ergebnis wird aus den Suchergebnissen entfernt.

- Meine Seite wird als negativ bewertet, weil zu viel Duplicate Content existiert.

B) Off-Page-Optimierung

Sind die technischen Weichen gestellt und die wesentlichen inhaltlichen Maßnahmen ergriffen worden, kann die Off-Page-Optimierung intensiviert werden. Wie der Begriff schon zeigt, kann man diese nicht direkt durch Maßnahmen auf der eigenen Seite beeinflussen. Wie im ersten Beitrag der SEO-Einsteigerserie erwähnt, mögen Suchmaschinen externe Links. Sie zeigen der Suchmaschine wie wichtig eine Seite ist, also welche Reputation sie im Netz hat. Was ein Backlink ist, warum Links überhaupt wichtig sind und wie man die ersten Links Aufbau, darüber habe ich im zweiten Teil meiner SEO-Einsteigerserie ausführlich berichtet.Fazit

Beim Optimieren kann man schnell den Überblick verlieren. Tools, wie der Screaming Frog SEO Spider, helfen dabei, den Ist-Zustand der Seite zu analysieren. Dann kann schrittweise die Optimierung in Angriff genommen werden. Die Optimierung startet in der Regel auf der eigenen Seite, also on-page. Nachdem ein technischer Check abgeschlossen ist, wird der Seiteninhalt als weitere On-Page-Maßnahme angepasst. Sobald hier ein großer Teil der Arbeit geleistet wurde, kann man sich den Off-Page-Maßnahmen, also der Reputation der eigenen Website im Netz, zuwenden. Wer an diesem Punkt angelangt ist, darf eines nicht vergessen: Die Optimierung ist ein fortlaufender Prozess, da sich u. a. das Suchverhalten der Nutzer ändert oder die Ansprüche der Suchmaschinen steigen. Insofern lohnt es sich, die Seiten kontinuierlich zu optimieren.Alle Artikel aus der Serie SEO für Einsteiger

Teil 1: Die Funktionsweise von Suchmaschinen

Teil 2: Wie baue ich meinen ersten Link auf?

Teil 3: Keywords, Keywords, Keywords

Teil 4: Wo fange ich eigentlich mit SEO an?

Teil 5: Tipps für die Homepage

Teil 6: Strukturierte Daten, Markups & co.

The following two tabs change content below.

Andreas Engelhardt

Andreas Engelhardt ist Head of Digital Analytics + CRO bei der Online-Marketing-Agentur Bloofusion.

Dort berät er Kunden bei der Webanalyse und der Optimierung ihrer Seiten für mehr Sales und Leads. Zudem bloggt er regelmäßig im Bloofusion Blog.

Andreas Engelhardt ist unter anderem in den folgenden sozialen Netzwerken zu finden:

Neueste Artikel von Andreas Engelhardt (alle ansehen)

- Google Consent Mode Version 2 – Alles, was du wissen musst - 1. März 2024

- Recap „Conversion Day 2023“ - 20. September 2023

- [GA4] Der richtige Umgang mit Bot-Traffic - 6. September 2023

- Optimiere deine Datenanalyse: Verknüpfe Google Analytics 4 mit BigQuery - 17. Mai 2023

- GA4: ja, nein oder vielleicht? - 27. April 2023

Oktober 11th, 2019 at 19:58

Vielen Dank für die sehr gut verständlichen SEO Tipps. Meine Frage betrifft den Bereich Meta-Daten. Darin können Sonderzeichen integriert werden. Diese dienen dazu, dass das betreffende Suchergebnis in Google von den Interessenten besser wahrgenommen wird. Welche Sonderzeichen werden von Google akzeptiert bzw. dann in den Suchergebnissen abgebildet? Hätten Sie dafür einen Tipp? Besten Dank im Voraus!

Oktober 12th, 2019 at 18:13

Vielleicht hilft Dir diese Auswertung weiter:

https://www.sistrix.de/news/emojis-in-google-serps/

Dort stellen die Sonderzeichen, die auch wirklich in Suchergebnissen gefunden wurden. (Für die volle Liste am Ende auf das Google Sheet klicken)